Ligado a la creación de los primeros ordenadores, los monitores son un elemento clave al momento de utilizar estas máquinas. Siendo el principal dispositivo de salida del ordenador, se fue modernizando a la par con estos aparatos, ofreciendo mayor calidad y definición en cada nuevo modelo.

La historia del monitor de ordenador

Se considera al monitor como un periférico de entrada y salida, si se trata de uno táctil o multitáctil, que muestra la información de manera gráfica de un ordenador funcionando a través de una tarjeta, llamada gráfica o de vídeo. De esta tarjeta y de la tecnología utilizada para formar las imágenes en el monitor dependerá la calidad y resolución de las imágenes proyectadas.

Hoy en día, las pantallas que contienen los ordenadores de escritorio o portátiles son muy superiores, brindando una alta calidad de imagen y gran definición gracias al uso de millones de colores para crear gráficos complejos, a diferencia de los primeros ordenadores que sólo mostraban un color, pero que sentaron las bases para la creación de mejores pantallas con cada nuevo modelo de ordenador.

Primeros monitores

Antes de poder utilizar un monitor para manejar el ordenador, se utilizaba un teletipo que se conectaba al ordenador e imprimía los datos de una sesión informática. A partir de la década del 70, comenzaron a aparecer los primeros monitores de CRT (tubos de rayos catódicos), creados por Karl Ferdinand Braun y utilizados también para los televisores de esa época.

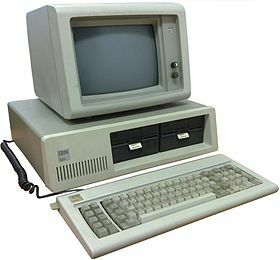

EL primer monitor de ordenador con pantalla CRT fue fabricado por IBM y era parte de su ordenador IBM PC. Estos primeros monitores seguían el estándar de tarjetas de exhibición de vídeo MDA (Monochrome Display Adapter) y eran monocromáticos, soportando sólo texto, subrayado, negrita y cursiva. La IBM PC se convirtió así en un ordenador de tres piezas, ya que presentaba el monitor, teclado y CPU por separado.

Luego aparecen los monitores adaptados a color con la tarjeta gráfica CGA (Color Graphics Adapter) que fue desarrollado también por IBM en el año 1981. Esta tarjeta permitía la proyección de cuatro colores y una resolución de 320 x 200 píxeles. Por un tiempo, las tarjetas MDA y CGA compartieron el mercado y los clientes elegían el monitor monocromático por su bajo precio.

En el año 1984, la empresa IBM desarrolla otra tarjeta de exhibición de video, EGA (Enhanced Graphics Adapter) para un monitor que mostraba 16 colores y una mayor resolución que los anteriores, de 640 x 350 píxeles.

Una de las tarjetas más importantes de la empresa fue la VGA (Video Graphics Array), creada en 1987, que fue muy bien recibida por la industria. Esta tarjeta se siguió modificando para solucionar ciertos problemas, presentando SVGA (Super VGA), la que determinó las bases para las tarjetas gráficas actuales. La VGA permitía una visualización de 256 colores y resolución de 640 x 480 píxeles, esta amplia paleta de colores hizo posible la visualización de gráficos y fue un gran avance para visualizar en los ordenadores más que texto.

Cambios en la década del 90

Con la aparición de la XGA (eXtended Graphics Array) en 1990, las posibilidades del monitor de ordenador se potenciaron. Esta tarjeta permitía visualizar 16,8 millones de colores en una resolución de 800 x 600 píxeles, mostrando los colores muy similares a los que percibe el ojo humano en la vida real.

Esta tarjeta y su sucesora UXGA (Ultra eXtended Graphics Array) con una resolución de 1.600 x 1.200 píxeles se utilizaban en los monitores CRT de 21 y 22 pulgadas y también en los novedosos monitores LCD, creados por Jack Janning.

Aunque la primera experimentación con pantallas de cristal líquido se realizó en 1968, no fue hasta esta época que el monitor CRT de ordenador comenzó a ser reemplazado lentamente por los LCD, que permitían construir pantallas de 21 pulgadas o más. Esta pantalla representó una revolución para la industria de los ordenadores personales ya que gracias a su menor grosor comparado con los monitores CRT podían aplicarse a ordenadores más pequeños y portátiles.

¿Qué tipos de monitores hay?

Además de los ya mencionados CRT y LCD que fueron los primeros en ingresar a la industria, hay actualmente una gran variedad de tipos de monitores que se adaptan a distintas necesidades dentro del mercado.

Según la tecnología que emplea el monitor para formar las imágenes, hay distintos modelos de pantallas. El primero es CRT, un monitor de rayos catódicos que se utilizó en los primeros ordenadores de la historia y se caracterizaba por tener una pantalla curva, que luego desaparece con los avances tecnológicos en las pantallas. Luego lo reemplazaron los LCD, pantallas de cristal líquido y planas.

Por otro lado, podemos encontrar PDP (Plasma Display Panel, o pantalla de plasma), TFT LCD (Thin Film Transistor o transistor de películas finas), la pantalla LED (Light Emitting Diode, o diodo emisor de luz), OLED (Organic Light-Emitting Diode, o diodo orgánico de emisión de luz), AMOLED (Active Matrix OLED, u OLED de matriz activa) y Super AMOLED.

Tamaño, resolución y píxeles en un monitor

Para definir el tamaño de un monitor, es necesario medir la diagonal que va de un vértice a otro opuesto, y las medidas se definen en pulgadas. Esta medida determina el tamaño real de la pantalla, excepto en los monitores CRT en los que se medía también el borde.

Por otro lado, podemos pensar en la proporción de una pantalla, que es la relación entre la medida del ancho con el alto. Si bien anteriormente la proporción más común tanto de ordenadores como en los televisores era de 4:3, luego se desarrollaron pantallas de 16:9 imitando la configuración de la pantalla de cine.

Otra característica importante de las pantallas es la resolución máxima de imagen, determinada por la cantidad de píxeles. Se define como el máximo de píxeles soportados en el eje X e Y, marcando la resolución de un monitor.

En las pantallas actuales, cada pixel contiene en su interior 3 subpíxeles de colores rojo, verde y azul. Estos tres van variando su brillo y así le dan color a cada píxel individual, asemejándose al sistema de color RGB (red, green and blue). La organización de los subpíxeles puede influir en la visualización de imágenes, por ejemplo la organización en diagonal o en triángulos es mejor para la sensación de movimiento en un monitor.

La aparición del monitor táctil

A medida que fueron avanzando las posibilidades de las tarjetas gráficas y con los distintos tipos de pantallas disponibles, la calidad de imagen de los ordenadores fue cada vez mayor, pero seguía manteniendo sus funciones básicas sin muchas modificaciones desde sus inicios.

Pero hubo un cambio que marcó fuertemente al mercado de los monitores, y esto fue la incorporación de pantallas táctiles en los ordenadores. A pesar de que primero se instalaron en dispositivos más pequeños como celulares y tabletas, cada vez más marcas deciden incorporar las pantallas táctiles en sus modelos de ordenadores para sumar flexibilidad al producto.

Las pantallas táctiles hacen que el monitor no se transforme sólo en un periférico de entrada, sino también de salida de datos permitiendo al usuario utilizar la pantalla para introducir información en el sistema. Es una forma mucho más intuitiva y sencilla de interactuar con un ordenador y muchos modelos incluso incorporan un lápiz óptico para mejorar la precisión del tacto.

Hace años que, además de estar presente en algunos modelos de ordenadores también son ampliamente utilizados en ordenadores públicos, como pueden ser los cajeros automáticos, las pantallas de información, los sistemas de venta de tickets y mucho más. Por lo que los monitores, si bien fueron pensados para los ordenadores profesionales y personales, encontraron otras aplicaciones para facilitar nuestra vida cotidiana de muchas maneras diversas.

Dejar una contestacion